El organismo estadounidense alertó por el aumento de estafas que usan videos manipulados para engañar a familias y compartió las claves para identificar falsificaciones.

A las herramientas de Inteligencia Artificial Generativa les cabe la lógica del martillo: dependiendo cómo se las use, pueden ser beneficiosas y productivas o, por el contrario, absolutamente destructivas. Una advertencia reciente del FBI da cuenta de esa dualidad. El organismo estadounidense alertó un aumento de casos en los que ciberdelincuentes usan IA para falsear secuestros de personas y extorsionar a las familias.

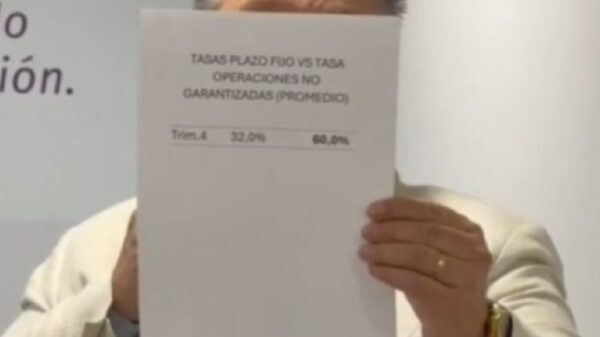

El eje de esta problemática son las deepfakes, un término que refiere a las falsificaciones profundas que se generan con herramientas de IA. En este caso, los actores maliciosos usan imágenes y videos tomados de las redes sociales, los editan con sistemas automatizados y generan clips que simulan un secuestro. El círculo se cierra cuando envían ese material a los allegados de esa persona, como una supuesta prueba de vida, extorsionándolos para que paguen un rescate.

“Los delincuentes suelen contactar a sus víctimas por mensaje de texto, alegando haber secuestrado a su ser querido y exigiendo el pago de un rescate por su liberación. Con frecuencia, el delincuente expresa serias acusaciones de violencia contra el ser querido si el rescate no se paga de inmediato. Posteriormente, envían una foto o un video aparentemente real del ser querido”, detalló el FBI en un comunicado.

Secuestros simulados con IA y extorsiones: los consejos del FBI para eludir el engaño

La problemática va en aumento. Sin embargo, una serie de variables ayudarían a identificar las deepfakes, que en este caso se emplean en un esquema delictivo y extorsivo.

“Una inspección minuciosa (de los videos falsificados) suele revelar inexactitudes en comparación con las fotos reales. Por ejemplo, la ausencia de tatuajes o cicatrices, así como proporciones corporales inexactas”, explicó el organismo de investigación que depende del gobierno de Estados Unidos.

En este punto, hay que tener en cuenta un detalle: a sabiendas de esas inconsistencias en las deepfakes, es usual que los delincuentes envíen el material con un tiempo de caducidad preestablecido. Es decir, solo puede ser visto una vez y luego desaparece, evitando de ese modo que las posibles víctimas realicen una inspección detallada. Otra dificultad es la creciente sofisticación de los generadores, capaces de crear falsificaciones cada vez más convincentes.

En ese marco, el FBI instó a limitar la información personal que comparten en línea, y a ser selectivos sobre quién puede ver fotos o videos familiares. Finalmente, también recomendaron que se intente establecer una conexión directa con la supuesta víctima del secuestro antes de cumplir con cualquier perdido de rescate y extorsión.