“Nuestro método permite un control sin entrenamiento ni ajuste, y es una forma más eficiente de implementar correcciones en tiempo real”, dice el autor del estudio, en el que también participa la firma Nvidia.

Cuando un robot se equivoca, habitualmente su desarrollador recopila nuevos datos e insiste en el entrenamiento del modelo que gobierna el comportamiento de la máquina. Investigadores de la Universidad Tecnológica de Massachusetts, el célebre MIT estadounidense, proponen un camino alternativo para educar a los autómatas. El plan es que la participación humana sea mayor, en el marco de un método que emula las interacciones entre las personas de carne y hueso.

Humanos, robots y aprendizaje: un método inspirado en la vida real

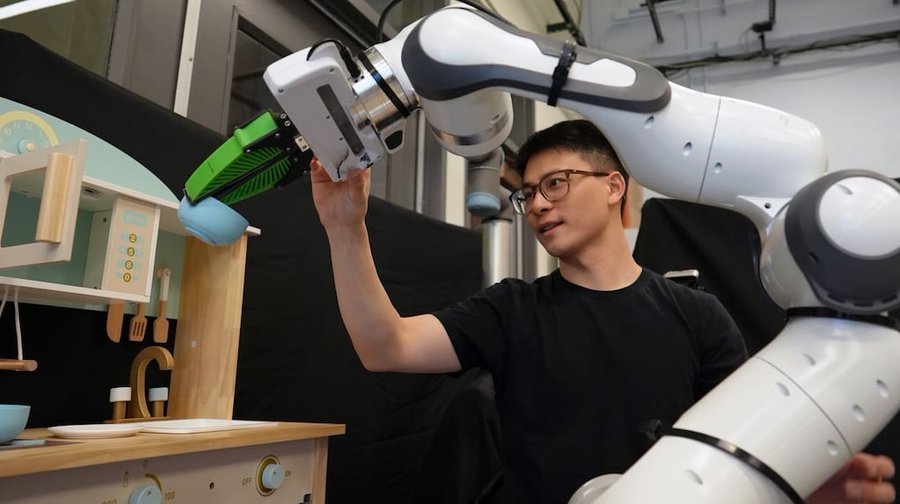

Igual que una maestra de danza que corrige a sus alumnos con sutiles contactos que indican hacia dónde debería moverse una mano durante un giro, por mencionar un ejemplo bien gráfico; el método propuesto en un reciente estudio del MIT se basa en la retroalimentación humana. Por ejemplo, si el robot falla al intentar agarrar un objeto, el operador —uno de los nuestros— corrige guiándolo hacia la dirección indicada. También se contemplaron otras posibilidades. Por caso, señalar el objeto o trazar la trayectoria hacia él en una pantalla.

La clave es que el robot comprenda las intenciones del usuario y que no sea necesario ser un experto para realizar las correcciones. Esto último es central para que, más pronto que tarde, los autómatas entrarán de lleno en los hogares, fábricas, comercios y calles del mundo real. Las pruebas fueron auspiciosas: según dicen desde el MIT, la tasa de éxito de este método fue un 21% mayor en comparación con procedimientos que no se basan en intervenciones humanas.

“Los usuarios querrán métodos intuitivos para corregir a los robots”

Las máquinas pueden realizar trayectos válidos (por ejemplo, mover su brazo en dirección a la supuesta ubicación de un objeto), pero eso no significa que siempre se alineen con la voluntad del usuario en los entornos reales. Por caso, un robot podría haber sido entrenado para recoger cajas de un estante y se moverá en consecuencia. Ahora bien, ¿qué pasa si ese elemento se movió y está en una orientación diferente a la que el autómata aprendió durante el entrenamiento?

“No podemos esperar que personas sin conocimientos técnicos recopilen datos y ajusten un modelo de red neuronal. El consumidor esperará que el robot funcione desde el primer momento, y si no lo hace, querrá un mecanismo intuitivo para personalizarlo. Ese es el reto que abordamos en este trabajo”, comenta Felix Yanwei Wang, estudiante de posgrado en Ingeniería Eléctrica e Informática y autor principal de un artículo con detalles de los avances en la investigación.

– ¿Por qué no se empleó anteriormente este método en forma rigurosa, siendo que parece el más lógico, y especialmente el más natural, para entrenar a los robots?

– Estos métodos de interacción se han utilizado anteriormente, pero no en conjunto con modelos de Inteligencia Artificial Generativa. Antes de la reciente ola (de esas tecnologías), no existía una forma efectiva de aprender múltiples comportamientos dentro de un solo modelo. En consecuencia, cada modelo se limitaba a un solo comportamiento. Solo con la llegada de los métodos de IA Generativa —capaces de aprender múltiples comportamientos en un solo modelo— surgió la necesidad de guiar al robot hacia un comportamiento específico, junto con la oportunidad de explorar plenamente el potencial de estos métodos intuitivos de interacción con el usuario.

– El mundo real es mucho más cambiante que los paquetes de datos utilizados para entrenar a las máquinas. ¿Cómo se aborda esta disyuntiva?

– El nuestro no es un “método de entrenamiento” en el sentido convencional. Entrenar o aprender un modelo generalmente implica modificar sus parámetros. En cambio, tomamos modelos preentrenados (entrenados con otros métodos) y mantenemos sus parámetros fijos, centrándonos en controlar su comportamiento sin entrenamiento adicional.

Los enfoques anteriores para adaptar el comportamiento del modelo a menudo requieren la recopilación de nuevos datos en entornos de implementación para ajustar los parámetros. Nuestro método permite a los usuarios controlar el comportamiento del modelo sin entrenamiento ni ajuste, lo que lo convierte en una forma más eficiente de implementar cambios o correcciones en tiempo real durante la implementación.

– ¿Qué pasos siguen en esta investigación?

– Normalmente, empiezo identificando un problema real y analizando por qué es desafiante. Luego, examino el problema para encontrar un enfoque prometedor, uno en el que los métodos más recientes y avanzados probablemente logren avances significativos. A partir de ahí, mi contribución a la investigación se centra en mejorar los métodos existentes para abordar eficazmente el problema real.

Reentrenar a los modelos generativos es un proceso lento y costoso que, además, requiere conocimientos en aprendizaje automático (machine learning). Tal vez la solución está más cerca de lo que creíamos: los robots pueden ser controlados mediante acciones esencialmente humanas. “Buscamos un comportamiento mucho más acorde con la intención del usuario y mover físicamente al robot es la forma más directa de especificarlo sin perder información”, cierra Wang.

La investigación del MIT, que cuenta con la participación de especialistas de la firma Nvidia, será presentada en la Conferencia Internacional sobre Robótica y Automatización 2025 que se celebrará en Atlanta, Estados Unidos, a partir del 19 de mayo.